Wurde wirklich der geheime Google-Algorithmus veröffentlicht?

Eine größere Sensation könnte ich mir für die SEO Welt kaum vorstellen! Seit Jahren bezeichne ich (mit einem Augenzwinkern) den Google Algorithmus als "das wohl bestgehütete Geheimnis der Welt".

Für mich wäre das zumindest plausibel, wenn man bedenkt, was Google mit diesem Algorithmus (bzw. mit der Suchmaschine) verdient und welche monetäre Bedeutung er für Webseitenbetreiber hat, die auf Platz 1 angezeigt werden.

Der heilige Gral könnte nicht bedeutender sein!

Und seitdem ich mich der Suchmaschinenoptimierung verschrieben habe (also schon fast 20 Jahre) versuchen findige Nerds, diesen Algorithmus zu knacken und die wichtigsten Kriterien für ihre eigenen Seiten zu manipulieren.

Und nun wird bekannt, dass Teile dieses geheimen Suchalgorithmus von Google aus Versehen an die Öffentlichkeit gelangt sind.

Oder zu neudeutsch: Der Google Algorithmus wurde geleakt! 🤯😱

Disclaimer: Alle folgenden Aussagen sind Interpretationen (meine eigenen oder die anderer SEO Profis), die immer im Kontext betrachtet werden müssen. Auch wenn Google die Echtheit der Dokumente mittlerweile bestätigt hat, gibt es natürlich keine Verlautbarungen zu konkreten Rankingfaktoren oder anderen Erkenntnissen, die wir aus diesen Dokumenten ableiten. Wir wissen i.d.R. nicht, wie bestimmte Kriterien gewichtet werden oder ob sie überhaupt in der aktuellen Algorithmus-Version noch oder schon eine Rolle spielen.

Was ist passiert?

In einer turbulenten Folge von Ereignissen wurden über zweieinhalbtausend (!) Seiten der Google-Such-API-Dokumentation veröffentlicht, aus denen man über 14.000 wahrscheinliche Rankingfaktoren ableiten kann.

Aber eins nach dem anderen:

Mitte März tauchten auf GitHub Dokumente auf, die bei internen Code-Reviews versehentlich öffentlich zugänglich gemacht wurden. Diese Dateien waren niemals für die Öffentlichkeit bestimmt, aber aufgrund eines Fehlers in Googles internen Prozessen konnte man auch von außen auf sie zugreifen.

Ein automatisierter Bot hat diese Dokumente erfasst und auf Github veröffentlicht. Obwohl der öffentliche Zugriff also schnell entdeckt und korrigiert wurde, haben wir deshalb immer noch Zugriff auf diese Dokumente.

Wenn Du mal einen Blick hineinwerfen möchtest: GoogleApi. ContentWarehouse. V1.Model. CompressedQualitySignals

Der SEO-Experte Erfan Azimi, CEO einer Digital-Marketing-Agentur, teilte die Dokumente mit Rand Fishkin und Mike King, bekannten Persönlichkeiten in der SEO-Community, die die Inhalte analysierten und darüber berichteten.

Update 30.5.2024:

Google hat mittlerweile die Echtheit der Dokumente bestätigt!

Wie sind die Dokumente einzuordnen?

Mit einem Veröffentlichungsdatum vom 27. März scheinen diese Dokumente sehr aktuell zu sein und möglicherweise sogar den aktuellen Algorithmus zu beschreiben.

Fishkin beauftragte Mike King von iPoolRank, einen hochqualifizierten technischen SEO, mit der Analyse der technischen Aspekte der Dokumentation. King veröffentlichte seine eigenen Ergebnisse und bestätigte, dass das Leck eine außergewöhnliche Menge an bisher unbestätigten Informationen über die innere Funktionsweise von Google enthält.

Fishkin stellt klar, dass die erwähnten Funktionen kein schlüssiger Beweis für einen Google-Rankingfaktor sind. Das Leak bietet spannende und wertvolle Einblicke, aber es ist keine vollständige Blaupause des Google-Algorithmus.

Es wird nicht erwähnt, wie diese potenziellen Faktoren innerhalb des Algorithmus gewichtet werden, und einige der Elemente sind möglicherweise auch experimentell oder werden gar nicht mehr verwendet.

In den Dokumenten sind jedoch Funktionen, die überholt sind, deutlich gekennzeichnet. Dies deutet stark darauf hin, dass alles, was nicht als veraltet gekennzeichnet ist, derzeit auch im Algorithmus aktiv ist.

Was bedeutet das für uns als Webseitenbetreiber?

Ich glaube nicht, dass wir nun unsere gesamte SEO Strategie auf den Kopf stellen müssen. Im Gegenteil zeigt sich, dass viele der Kriterien, die wir als wahrscheinlich angenommen hatten, nun bestätigt werden.

Aber Vorsicht! Wenn wir in die Dokumente schauen, sehen wir eigentlich nur Verweise auf unterschiedliche Module, Variablen und Attribute, die offenbar für den Google-Suchalgorithmus relevant sind.

Beispiel für ein Attribut im Modul QualitySignals: offenbar ein experimentelles Qstar Delta Signal... 🤔

Wir sehen also nicht den Algorithmus selbst, sondern nur einzelne Zutaten.

Damit haben wir zwar immer noch keinen Beweis, aber wir nähern uns weiter der Realität. Und von der sind wir offensichtlich gar nicht so weit entfernt, denn viele Strategien der Suchmaschinenoptimierung zeigen ja den gewünschten Erfolg, lassen sich also auch statistisch beweisen.

Wir wissen schon lange, dass Google immer mehr Nutzersignale in das Ranking mit einfließen lässt. Das macht Sinn, denn Google will ja die Qualität der Ergebnisse weiter verbessern. Wer sonst als die User selbst sollten entscheiden, welche Inhalte gut sind und zur entsprechenden Sucheingabe passen?

Nun haben wir konkrete Anhaltspunkte, wie genau Google hier vorgeht.

Daher unterscheide ich die folgenden Erkenntnisse in solche, die mir persönlich neu sind und solche, die nicht so überraschend sind, auch wenn Google sie bisher dementiert hat.

Was bestätigt sich?

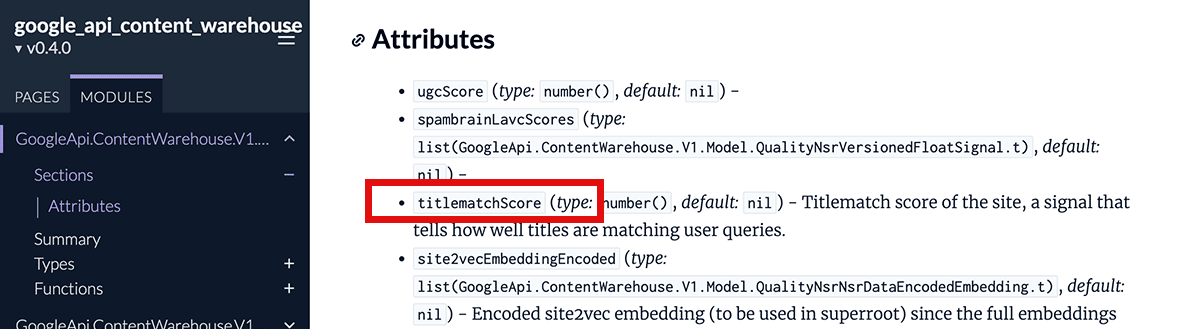

1. Der Seitentitel

Die Seitentitel sind nach wie vor entscheidend. Die Variable titlematchScore (also ein Wert für die Übereinstimmung von Title Tag und Suchanfrage) deutet darauf hin, wie wichtig es ist, das der Seitentitel mit der Suchanfrage übereinstimmt.

Mein Fazit: Der Title war und ist für mich einer der wichtigsten Faktoren der Suchmaschinenoptimierung. Das bestätigt meine Beobachtungen.

2. Die Domain-Authority

John Mueller behauptete immer wieder, dass es so etwas wie eine seitenweite Domain-Autorität nicht gäbe:

Sie sehen gerade einen Platzhalterinhalt von Standard. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf den Button unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Weitere InformationenDie Dokumente zeigen jedoch, dass Google eine Metrik namens "siteAuthority" bzw. "authorityPromotion" verwendet.

Das klingt für mich sehr nach Domain-Authority, zumal sich diese Metrik auf die gesamte Seite zu beziehen scheint.

Das Konzept des PageRank war ja bekannt und hat Google überhaupt erst so populär gemacht. Es hieß aber immer, diese Bewertung beziehe sich ausschließlich auf einzelne Unterseiten. Einen globalen Wert für die gesamte Website würde es nicht geben...

Und dass PageRank immer noch relevant ist, bestätigen die Dokumente mit einem Wert namens "homepagePagerank". Über die Bedeutung gibt es allerdings unterschiedliche Interpretationen.

Mein Fazit: Die Site-Authority in Kombination mit dem Homepage-Pagerank deutet für mich darauf hin, dass die Autorität Deiner Website wichtig ist bzw. immer wichtiger wird.

Das ist für mich nicht neu, das predige ich schon seit Jahren. Die Autorität lässt sich durch hochwertige Backlinks, Citations Deiner (Personen-)Marke oder andere externe Trust-Signale aufbauen.

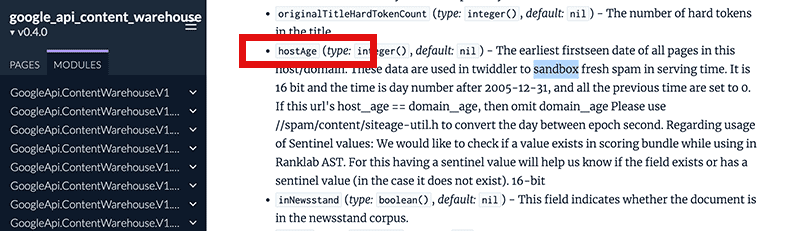

3. Die Sandbox

Schon in meinen ersten SEO-Erfahrungen musste ich mit meinen eigenen Seiten feststellen, dass es so etwas wie den Sandbox-Effekt geben muss. Google hat die Existenz einer Sandbox für neue Websites allerdings seit je her abgestritten.

Nun finden wir in der Dokumentation ein Attribut namens hostAge, das einen Zeitstempel enthält, an dem eine Seite das erste mal von Google erfasst wurde.

In der Erklärung wird die Sandbox für neue Seiten erwähnt.

Das bedeutet vermutlich, dass neue Websites bzw. frische Domains tatsächlich in den Rankings zurückgehalten werden können, bis sie als vertrauenswürdig eingestuft werden.

Mein Fazit: Ich empfehle meinen Kunden immer, eine neue Domain so früh wie möglich zu registieren und auch schon einen minimalen, aussagekräftigen Onepager zu veröffetnlichen, damit die Sandkasten-Phase schnellst möglich überwunden werden kann.

4. Die Backlinks

Backlinks haben offenbar unterschiedlichen Impact. King vermutet, dass auch die Indexierungsebene (indexing tier) einer Seite ihren Linkwert beeinflusst. Stell Dir vor, dass Google seinen Index in drei Stufen einteilt.

Die wichtigsten und häufig aktualisierten Inhalte werden im Flash-Speicher gespeichert, da sie am schnellsten abgerufen werden können.

Weniger wichtige Inhalte werden auf Solid-State-Laufwerken gespeichert, während Inhalte, die nicht oft aktualisiert werden, auf normalen Festplatten gespeichert werden.

Das bedeutet, dass der Link umso wertvoller ist, je höher die Seite eingestuft ist. King nimmt an, dass neue, aktuelle Inhalte als qualitativ hochwertig angesehen werden, also möchtest Du natürlich Backlinks von Inhalten, die entweder neu und aktuell sind oder sich in der obersten Ebene befinden.

Deshalb tragen Links von hochwertigen Seiten und von Newsseiten wesentlich effektiver zur Verbesserung Deiner Rankings bei als z.B. ältere Unterseiten. Das bedeutet wiederum, dass digitale PR derzeit eine der besten Möglichkeiten ist, um qualitativ hochwertige Links zu erhalten.

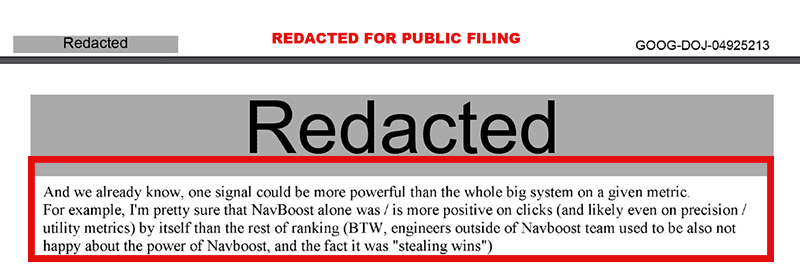

5. Das Klickverhalten

Google-Analyst Gary Ills betonte mehrfach, dass Klicks nicht direkt in die Rankings einfließen. Tatsächlich aber gibt es im NavBoost-Rankingsystem, das in der Dokumentation in 35 Modulen referenziert wird, ein spezielles Modul für genau solche Klicksignale.

Einfach ausgedrückt könnte man sagen, dass Google mit dem NavBoost System sowohl die Klicks in den SERPs selbst als auch das Verhalten nach dem Klick auswertet und in die Rankings einfließen lässt.

Dabei wird nicht nur zwischen guten und schlechten Klicks unterschieden, sondern es werden ganz unterschiedliche Daten gemessen und verarbeitet, z.B. auch das Datum des letzten guten Klicks auf ein Dokument...

Wenn Klicks keinen Einfluss auf die Rankings haben sollen, warum gibt es sogar unterschiedliche Qualitäten von Klicks?

- good clicks: hier sollen offenbar positive Interaktionen mit den Suchergebnissen odentifiziert werden

- bad clicks: gleiches natürlich auch für negative Interaktionen

- last longest clicks: hier geht es um die Zeit, die ein Nutzer nach dem Klick auf ein Suchergebnis auf der Website verweilt

- impressions: wie oft wird ein Ergebnis dem User angezeigt (vergleichbar mit den Impressionen in der Search Console)

- squashed clicks: Anzahl der Klicks, die als minderwertig oder als Spam eingestuft werden

- unsquashed clicks: Klicks, die als "echt" eingestuft werden

- unicorn clicks: besonders hochwertige Klicks, die durch einzigartige Merkmale auf außergewöhnliche Relevanz schließen lassen, z.B. bei einem perfekten Match zwischen der Suchanfrage und dem Ergebnis.

Für mich sieht das eher nach einer Schlüssel-Metrik aus, mit der die Relevanz und die Qualität eines Suchergebnisses dargestellt werden soll.

Dafür spricht z.B. auch eine veröffentlichte (allerdings zum Teil geschwärzte) Email von Googles Vizepräsident Alexander Grushetsky:

"Und wir wissen bereits, dass ein Signal mächtiger sein kann als das gesamte große System in Bezug auf eine bestimmte Metrik. Zum Beispiel bin ich mir ziemlich sicher, dass NavBoost allein mehr positive Auswirkungen auf Klicks hatte (und wahrscheinlich auch auf Präzisions- / Nutzbarkeitsmetriken) als der Rest des Rankings. Übrigens waren Ingenieure außerhalb des NavBoost-Teams auch nicht glücklich über die Macht von NavBoost und die Tatsache, dass es 'Gewinne stahl'."

Mit diesem System ahmt Google quasi das Verhalten sozialer Netzwerke nach, in denen das Engagement die wichtigste Kennzahl ist, die darüber entscheidet, wie populär ein Artikel ist.

Mein Fazit: Eine eindeutige Bestätigung dessen, wass viele SEOs schon lange vermutet (und auch danach optimiert) haben. Mach' also das Snippet so attraktiv wie möglich und halte Dein Versprechen im Content! Fokussiere Dich auf Deinen Leser, bediene vor allem dessen Suchabsicht (search intent) und biete hervorragenden Content.

Was ist neu?

6. Link Spam

Es gibt offenbar eine ganze Reihe von Metriken zur Bekämpfung von Link-Spam.

Im Grunde kann Google Spitzen bei Spam-Linktexten erkennen und negative SEO-Angriffe abwehren. Das ist beruhigend zu wissen, vor allem, wenn man bedenkt, dass es das Disavow-Tool vielleicht nicht mehr lange geben wird.

King konnte keine Erwähnung von Disavow-Daten finden und John Mueller hat ja mal angedeutet, dass Google das Disavow-Tool möglicherweise bald entfernen wird.

Google verfolgt auch das Datum der Domainregistrierung, wahrscheinlich um das Sandboxing über neue Inhalte und Domains, die den Besitzer gewechselt haben, zu informieren. Dies ist wahrscheinlich durch die Spam-Richtlinie zum Missbrauch abgelaufener Domains noch wichtiger geworden.

7. Nutzerdaten aus Chrome

Sowohl Matt Cutts (damals Leiter des Webspam-Teams) als auch Search Advocate John Mueller behaupteten, dass Chrome-Daten nicht für das Ranking verwendet werden.

Einige SEOs haben allerdings über einen einfachen Versuchsaufbau zeigen können, dass dem nicht so ist: Google wertet sehr wohl die Nutzerdaten aus Chrome für den Suchalgorithmus aus.

Nun haben wir es auch schwarz auf weiß:

Offenbar werden die Interaktionen der Chrome-User über das Attribut uniqueChromeViews verfolgt.

Ein weiteres Modul, das sich auf die Bewertung der Seitenqualität bezieht, enthält sogar einen Wert für die Aufrufe von Chrome auf Site-Level, und ein anderes Modul, das sich auf die Generierung von Site-Links bezieht, enthält ebenfalls ein Chrome-bezogenes Attribut.

Man munkelte ja schon lange, dass Chrome einzig zu diesem Zweck entwickelt wurde, um eigene Clickstream Daten zu generieren. Ein eigener Browser mit einer solchen Marktdurchdringung ist da natürlich eine Goldgrube!

Randnotiz: In einer Gerichtsverhandlung kam kürzlich heraus, dass Google selbst im Inkognito-Modus diese Daten erhebt, speichert und auswertet. Datenkrake Google...

Mein Fazit: Ich war schon lange davon überzeugt, dass Google nicht vor den Nutzerdaten des hauseigenen Browsers halt macht. Woher sonst sollte Google die sogenannten "Nutzersignale" bekommen, wenn nicht aus den eigenen Tools? Warum wohl bietet Google seine gesamte Suite kostenlos an?

Aus SEO Sicht ist es für uns allerdings nicht zu verwerten und das ist ja durchaus beabsichtigt: so wenig Manipulationspotential wie möglich.

8. User Signale aus dem lokalen Umfeld

Azimi behauptet, dass das Verhalten eines Nutzers die Rankings anderer Nutzer am gleichen Standort und im selben demografischen Umfeld beeinflussen können.

Fishkin bringt dazu folgendes Beispiel: Wenn viele Menschen in Seattle nach Lehman Brothers suchen und so lange scrollen, bis sie die Website des Lehman Brothers Theaters finden, wird Google schnell erkennen, dass es das ist, was die Menschen in Seattle wollen, wenn sie die Anfrage eingeben.

Da erscheint dann eben nicht mehr den Wikipedia-Link zu dem gescheiterten Finanzunternehmen finden.

Weiter sagt er, wenn Du bei genügend Suchenden in Deiner Zielregion eine hohe Nachfrage für Deine Website erzeugst, könntest Du sogar übliche SEO-Signale wie Links und optimierte Inhalte ignorieren und trotzdem gut ranken.

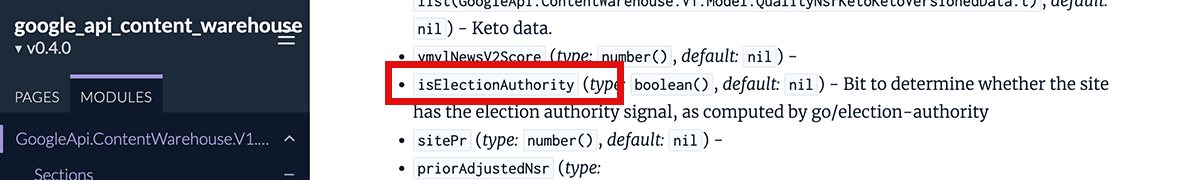

9. Authority Whitelisting

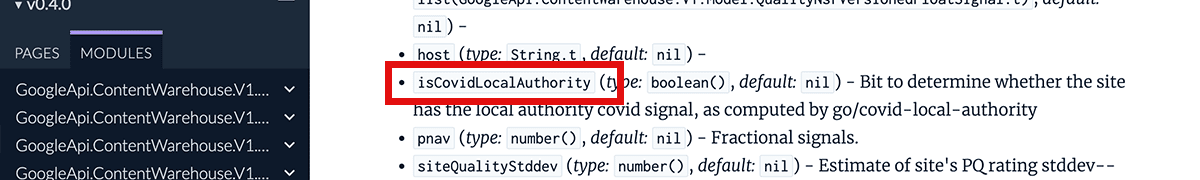

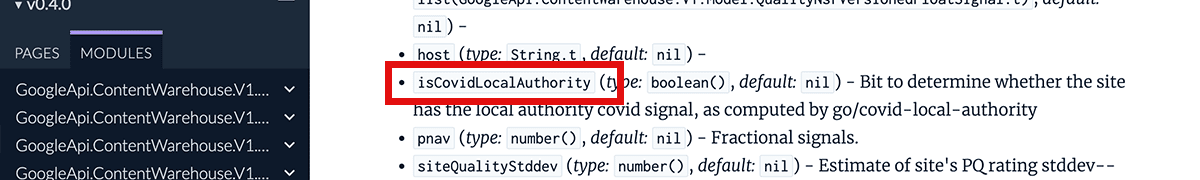

Achtung, jetzt wird es düster! Es gibt offenbar Whitelisting-Signale für bestimmte Ereignisse oder Anbieter. Dazu gehören politische Wahlen, eine Covid19 Pandemie oder Google-eigene Bestellplattformen für Nahrungsmittel... 😱

In der Praxis kann das heißen, ...

...dass bei der nächsten Bundestagswahl bestimmte Nachrichten-Websites ein Whitelist-Joker haben und so in den Suchergebnissen zu themenrelevanten Suchanfragen zu Wahlentscheidungen bevorzugt gelistet werden.

...dass bei der nächsten Pandemie über eine simple Boolean-Variable (ja/nein) bestimmt werden kann, welche Experten den Konsens bilden. Seiten ohne diesen Joker haben keine Chance auf relevante Platzierungen.

...dass Google bestimmten Restaurants oder Bestell-Apps ("who is Google owned first party food ordering platform") eine Vorzugsbehandlung angedeihen lassen kann, wenn es dafür einen Grund (oder Nutzen) gäbe... 🤔

Mein Fazit: Vergessen wir mal die Suchmaschineneoptimierung. Für mich tun sich hier finstere Abgründe auf, denn niemand weiß, wie diese Signale zustande kommen oder wer darüber entscheidet. Mit diesem simplen Werkzeug lassen sich ganze Gesellschaften oder Nationen manipulieren und die Vergangenheit hat gezeigt, dass dies auch genutzt wird. Diese Thematik sollte viel mehr Öffentlichkeit und Aufmerksamkeit bekommen und müsste (ähnlich wie das Thema Datenschutz) dringend regelementiert werden.

Was nicht eindeutig ist

9. Small Personal Websites

Interessanterweise hat Google eine eigene Kennzeichnung für kleine persönliche Websites. Was genau das bedeutet, ist zwar nicht bekannt, aber es könnte dazu dienen, solche Websites entweder aufzuwerten oder zurückzustufen.

Google verfolgt auch die durchschnittliche Schriftgröße für Begriffe und Ankertexte. Dies liegt wahrscheinlich daran, dass viele Menschen die Überschriftenformatierung nicht richtig verwenden. Daher verwendet Google die Schriftgröße, um die beabsichtigten Überschriften auf einer Seite zu bestimmen.

10. Die Autoren-Details

Google speichert explizit den Autor einer Seite und ob eine Entität ist. Google interessiert sich offenbar dafür, wer Deine Autoren sind, was ja ein wichtiges Element von EAT bestätigt.

Was wird abgestraft?

Es gibt auch eindeutige Beweise dafür, dass eine Herabstufungen durch den Algorithmus eine Vielzahl von Gründen haben kann:

- Anchor-Mismatch: wenn also ein Link für die Website, auf die er verlinkt, nicht relevant erscheint

- SERP Devotion: hängt wahrscheinlich mit der Unzufriedenheit der Nutzer zusammen - gemessen am Klickverhalten (CTR in den SERPs)

- NAV Devotion: trifft wahrscheinlich auf Seiten mit schlechter Navigation oder Benutzererfahrung zu

- Exact-Match-Domains: offenbar sinken Exact-Match-Domains weiter im Wert

- Local Devotion: also eine standortabhängige Herabstufung, was darauf hindeutet, dass Google versucht, Seiten mit einem Standort in Verbindung zu bringen und sie entsprechend einzustufen

Warum lügt Google?

Es gibt viele erregte Stimmen im Netz, die von der großen Google-Lüge sprechen. Google sei unehrlich mit uns Seitenbetreibern und mit uns SEO Profis gewesen.

Ich persönlich kann das allerdings ganz gut nachvollziehen. Seit Anbeginn der Suchmaschinen haben Technik-Freaks versucht, sich auf die vordersten Plätze der Suchergebnisse zu mogeln. Auch das ist nachvollziehbar.

Das Problem bei der Sache: Sobald es einen konkreten Wert gibt, den man für die Bewertung einer Website heranzieht und diesen auch bekannt macht, wird es Leute geben, die versuchen diesen Wert künstlich zu beeinflussen.

Damit wird das Bewertungskriterium unbrauchbar, weil es völlig verzerrt wird.

Beispiel: Würde Google einfach nur zählen, wie oft ein Keyword im Text vorkommt, werden clevere Websitebetreiber einfach die Zahl der Keywords erhöhen. Und schon ist die Quantität von der Qualität entkoppelt (genau das ist ja auch passiert - ist also nicht mehr clever).

Das Wichtigste zum Schluss

Die wohl wichtigste Erkenntnis: Der Aufbau Deiner Marke ist das Wichtigste, wenn Du heutzutage in der Google-Suche sichtbar werden willst.

Fishkin bringt es auf den Punkt:

"Wenn ich einen universellten Tipp geben müsste für Marketer, die ihre organischen Suchrankings und den Traffic insgesamt verbessern möchten, dann wäre es: 'Baue eine bemerkenswerte, beliebte und anerkannte Marke in Deiner Nische auf, außerhalb der Google-Suche."

Das wiederum würde ja bedeuten, dass sich Suchmaschinenmarketing um 180 Grad dreht.

Bis vor ein paar Jahren war SEO ein Entdeckungskanal, mit dem Du Deine anderen Kanäle aufbauen konntest. Nun sieht es so aus, als würde der Aufbau einer Marke außerhalb von Google schließlich auch positiv auf den organischen Google-Traffic abfärben würde.

* * *

Dies waren nur einige der wichtigsten Erkenntnisse, aber das ist bei weitem noch nicht alles. Warten wir ab, wie es weitergeht und was noch ans Tageslicht kommt.

Ich persönlich finde diese Enthüllungen total spannend! SEOs auf der ganzen Welt werden die Dokumente in den kommenden Monaten auswerten. Wenn es weitere wichtige Enthüllungen gibt, werde ich hier weiter darüber berichten. Wenn Du meinen Newsletter abonniert hast, wirst Du als erstes darüber erfahren.